|

之前分享了超级易上手的Midjourney学习内容,但要论工业化的AIGC,特别是想要在游戏行业稳定产出质量达标的内容,很多人会有一个共同答案,那就是Stable Diffusion。作为一款多平台适配的开源工具,Stable Diffusion虽然学习门槛略高,但它的输出效果、可控性和自由度一定配得上一句“值得”。我们就从今天开始学起吧! 所有资料均来自互联网,侵删。同时也希望大家尊重知识产权哦~

SD秋叶包下载地址/下载方式教学 下载完的界面

SD教程

stable-diffusion-tutorial SD教程

点击跳转

一、前言SD 效果图展示: 动漫插画,就说这效果强不强吧... 是不是迫不及待想试一试了呢,那我们开始吧,手把手教学,外婆真的看了都会的教程,开始进入教学!!

二、Stable Diffusion 介绍Stable Diffusion 是一款基于人工智能技术开发的绘画软件,它可以帮助艺术家和设计师快速创建高品质的数字艺术作品。该软件使用了一种称为 GAN(生成对抗网络)的深度学习模型,该模型可以学习并模仿艺术家的创作风格,从而生成类似的艺术作品。 Stable Diffusion 具有直观的用户界面,可以让用户轻松地调整绘画参数并实时预览结果。用户可以选择不同的画布、画笔和颜色,还可以通过调整图像的风格、纹理和颜色等参数来创建各种不同的艺术作品。 除此之外,Stable Diffusion 还提供了一些高级功能,例如批量处理、自动矫正和自动化调整等,可以帮助用户更加高效地完成大量的绘画任务。 总之,Stable Diffusion 是一款功能强大的 AI 绘画软件,它比现在市面上主流的 AI 绘画软件 Midjourney 更加的强大,可以说 SD 是所有 AI 绘画的鼻祖级存在,同样,更强大代表着它的上手难度及配置要求也更高。那么说到这里,我们就来看看这两款软件的一个对比吧

三、主流 AI 绘画软件的对比

四、Stable Diffusion 电脑配置要求1. 配置要求: 需要使用 N 卡(NVIDIA 显卡),显卡的显存至少需要 4GB 以上显存才能在本地运行。最低配置需要 4GB 显存,基本配置 6GB 显存,推荐配置 12GB 显存或者以上。 Stable Diffusion Ai 绘画主要是运行显卡,算力越强,出图越快。显存越大,所设置图片的分辨率越高) “推荐使用 RTX4090 显卡哦” -----来自一个 3080 显卡玩家 还有一点的就是硬盘空间要大,SD 出图主要依赖模型,网上下载的模型资源一般都很大(一个模型在 2G 以上)批量跑图也是很占内存的,这边建议 60GB 以上的硬盘空间。 2. 网络要求:大家都懂哈,咱也不说。 3. 操作系统:需要是 Win10 或 Win11。 满足以上条件基本上就可以用 SD 跑图啦。

五、Stable Diffusion 安装SD 的安装我们就不要整的很复杂了,直接用大佬制作的一键安装/启动包就行,我们把时间用在刀刃上。 自己手动安装需要上 Github 下载文件,还要下载 Ptthon 等工具,一般第一次手动安装会出现各种奇怪的报错,总之很复杂,我之前自己安装过,真就花了一上午都还没安装好。所以我不建议也不教大家手动安装了。(如果你要硬上,可以在网上看看别的使用教程) 上黑科技!!!咱直接去使用@秋葉 aaaki 大佬的免费启动器和安装包。 点击跳转

我们下载这两个文件,下载链接在这篇文章顶部: 注意:下载的文件一定要放在空间比较大的盘里。 来看下具体操作: 1. 安装一下这个“启动器运行依赖”。 2. 然后把这两个文件复制一下,我们需要粘贴到“webui:文件夹中 3. 粘贴替换目标中的文件。粘贴的位置看我的文件夹路径。 4. 这里我重新走一遍打开流程,以防大家退出去了不知道从哪里进。我们打开下载的文件夹,然后进入到“novelai-webui”文件夹 5. 打开“novelai-webui-aki-v3”文件夹。 6. 然后下拉下拉...找到这个启动器,双击就完事了,这个就是我们刚刚粘贴替换的文件。 7. 然后就打开啦,一键启动就好了。

六、Stable Diffusion 基础操作

1. 大模型的切换 checkpoint

首先是这个界面左上角,在这里可以切换你所安装的模型。 然后我们在 C 站上下载一些模型: 接下来就是安装了,很简单,把下载的模型放到这个路径文件夹中。然后刷新 web UI 界面(就是 SD 操作界面)

2. lora模型我们需要安装LoRA的插件,启动我们的Wbe UI切换到【扩展】tab下的【可用】一栏点击【加载自】按钮,在列表中找到,Kohya-ss Additional Networks这个插件点击右侧的【Intall】按钮,可能需要等待一会安装完成后【可用】tab下的【重启并应用用户界面】,重启之后如果看到顶层TAB上多了【Additional Networks】,就说明插件已经安装成功了。 接下来我们就需要下载我们喜欢的LoRA文件并使用了,我们还是去civitai网站,这里我使用的是现在比较火的Korean Doll Likeness以及Taiwan Doll Likeness两个LoRA,将两个文件下载完成后,把文件移动到整合包目录里的\extensions\sd-webui-additional-networks\models\lora位置。 移动完成以后我们关掉Web UI重新从启动器启动,在下图图示位置就能找到你的LoRA文件了,你也可以在civitai下载你喜欢的其他LoRA。 与底模型不同LoRA是可以多个混合使用的,接下来我们先点击下图的【启用】按钮,然后分别选择我们刚才下载的两个LoRA文件,右侧的混合权重那里一般建议0.6-0.8就行,你想要哪个模型的特点明确一些就把哪个调的高一些。 图片加载中 调整完成后你肯定要问了,我去哪里找这些提示词呢一般civitai网站模型主页下面作者的例图上都会有对应图片的关键词我们可以从那里复制改动一下就行。比如下图这个:可以看到除了提示词和反向提示词之外还有些其他参数,我会在下图按顺序标注这些参数在Web UI的位置。Seed这个不需要关注,除了Sampler、CFG scale、Steps之外,图片的宽高也需要我们注意这里建议默认使用512*768或着反过来,这样生成的速度比较快。这些内容都填写完成后,我们就可以点击右侧的【生成】按钮了。

3.模型的 VAEVAE 的全称是 Variational Auto-Encoder,翻译过来是变分自动编码器,本质上是一种训练模型,Stable Diffusion 里的 VAE 主要是模型作者将训练好的模型“解压”的解码工具。 这里可以切换 VAE。一般情况下我们就选择第一个自动就行了。 在 C 站下载模型,在下载页面会有文件显示,如图。 VAE 的安装路径看我这里,把下载的文件复制粘贴,然后把 web UI 界面刷新一下(就是 SD 操作界面) 言川总结: 1. 总的来说就是你在 C 站上下载的模型有些内置就有 VAE 的属性(不需要下载 VAE 文件),有些没有内置下载的时候我们就把 VAE 文件下载。(VAE 文件一般大小在几百兆左右) 2. VAE 的作用就是没有加载 VAE 的图片是灰灰的,加载之后就是会产生一个润色的效果,色彩更加丰富。

七.功能选项

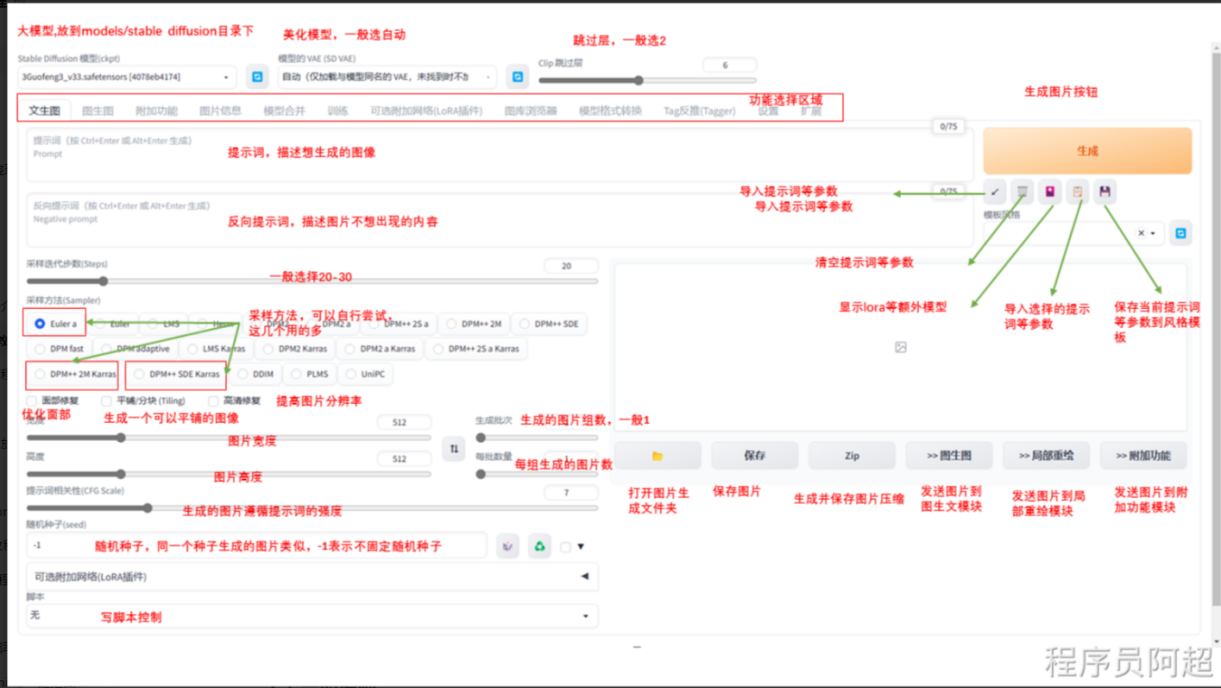

1.文生图

下面这块参数就是设置图片的一些基本参数,分辨率、尺寸等等,具体参数见下文。

2.图生图图生图,这个也很好理解,放参考图然后输入提示词,与其他 AI 绘画软件一致。 图片信息,意思是你用 SD 画的图,放在这里来,右边会显示这个图片的一些参数,包括关键词。 3. 提示词和反向提示词提示词内输入的东西就是你想要画的东西,反向提示词内输入的就是你不想要画的东西。 提示框内只能输入英文,所有符号都要使用英文半角,词语之间使用半角逗号隔开。 一般来说越靠前的词汇权重就会越高,比如我这张图的提示词: The personification of the Halloween holiday in the form of a cute girl with short hair and a villain's smile, (((cute girl)))cute hats, cute cheeks, unreal engine, highly detailed, artgerm digital illustration, woo tooth, studio ghibli, deviantart, sharp focus, artstation, by Alexei Vinogradov bakery, sweets, emerald eyes。 万圣节假期的拟人化形式是一个留着短发和恶棍笑容的可爱女孩,可爱的帽子,可爱的脸颊,虚幻的引擎,高度详细,艺术种子数字插图,woo tooth,吉卜力工作室,deviantart,锐利的焦点,artstation,由 Alexei Vinogradov 面包店,糖果,绿宝石般的眼睛。 第一句关键词词组:万圣节假期的拟人化形式是一个留着短发和恶棍笑容的可爱女孩。那生成的图片主体画面就会是万圣节短发可爱笑容女孩 这里可能有用过 Midjourney 的小伙伴们就有疑问了,(((cute girl)))是什么意思,为啥有这么多括号,我来为大家解答下,这个是权重调节,类似 Midjourney 的 :: ① 最直接的权重调节就是调整词语顺序,越靠前权重越大,越靠后权重越低,上面说过。 ② 可以通过下面的语法来对关键词设置权重,一般权重设置在 0.5~2 之间,可以通过选中词汇,按 ctrl+↑↓来快速调节权重,每次调节为0.1,也可以直接输入。 ③ 加英文输入的(),一个括号代表这组关键词的权重是 1.1,两个括号是 1.1*1.1 的权重,不要加太多了哈。可以结合第二点固定权重,比如(((cute girl:1.2))),那这个关键词的权重就很高了。

4. 功能按钮我们来介绍下右边这几个功能,生成就不说了,输入关键词生成就跑图了。 第一按钮的意思是读取你上一张图的所有参数信息(包括关键词),比如你画一张图之后,关掉了软件,再次启动点击这个就会把参数复制进来。 第二个按钮就是删除了,清空关键词;这里可以和第一个按钮结合用哦 第三个按钮就是模型选择管理 这个按钮就是点击就会出现这些功能,你安装的模型和 Lora 都可以在这边调整。 这里可以把你生成的图片添加到模型的封面上,方便你后面看这个模型的效果,看我怎么做: 找到这个模型的名称,然后我这里是跑出来一张图片的,点击这个按钮(lora 一样) 最终效果: 后面两个就是一个提示词模板功能: 我们可以先点最后一个按钮,把现在的关键词创建一下,取个名字 然后在模板风格这里选中我们刚刚创建的模板(可以多选) 选中之后按一下第四个按钮,我们创建的关键词就被填入进去了,这块收工!

5. 采样步数一般来说大部分时候采样部署只需要保持在 20~30 之间即可,更低的采样部署可能会导致图片没有计算完全,更高的采样步数的细节收益也并不高,只有非常微弱的证据表明高步数可以小概率修复肢体错误,所以只有想要出一张穷尽细节可能的图的时候才会使用更高的步数。(加大这个会导致出图变慢)

6. 采样方法Stable diffusion webui 是 Stable diffusion 的 GUI 是将 stable diffusion 实现可视化的图像用户操作界面,它本身还集成了很多其它有用的扩展脚本。 SD 的采样方法有很多,大家有兴趣了解的可以去知乎看看@刘登宇的一篇文章《stable diffusion webui 如何工作以及采样方法的对比》。这里我们只介绍两个种常用的。 这里的采用方式有很多,但是我们常用的就那几个,我们可以去设置里面把不需要用到的关掉,不展示在这个界面中。然后点击右边的重启 UI 就好了。

7. 高清修复和图片尺寸参数前面两个做个简单的介绍,面部修复对写实的风格有点效果,可平铺就不要用了,生成的图片很奇怪,可以自己试试。 我们说说高清修复,高清修复的意思是把基础生成的图片,按照你选择放大的倍率放大到指定分辨率之后再重新绘制图片,受到你重复幅度调节的数值影响。 宽度、高度就是图片的长宽比,很容易理解,生成批次和数量就是几批,一批几张图,配置好的可以直接拉满,增加效率哦。 提示词相关性:图像与你的提示的匹配程度。增加这个值将导致图像更接近你的提示(根据模型),但它也在一定程度上降低了图像质量。可以用更多的采样步骤来抵消。 默认未选中高清修复是这样的,当前图片的参数。

8. 随机种子(seed)这个功能与 Midjourney 的 Seed 功能一样。 随机数的起点。保持这个值不变,可以多次生成相同(或几乎相同,如果启用了 xformers)的图像。没有什么种子天生就比其他的好,但如果你只是稍微改变你的输入参数,以前产生好结果的种子很可能仍然会产生好结果。 输入不同的种子,生成的图片不一样,seed 值一样,那生成的图片也是一样。 差异随机种子,需要勾选这个按钮: 这个功能是固定一个种子,然后调整差异强度来生成图片,因为是固定的 seed 值,所以生成的图风格都是类似的。 直接看图吧。 这边的几个功能都很简单,大家尝试下就能理解了,那基础操作我们就先讲到这里,大家赶紧玩起来吧!!

9.Control net插件(1:插件安装与模型下载 ①插件安装 一般来说,网上的整合包已经包含了 controlnet 插件,不需要额外安装。 安装方式: 1.选择到从网址安装:点击跳转(推荐) 2.可以直接去这个链接这里下载:点击跳转,然后解压到 extension 文件夹

②模型下载 我们可以直接去:点击跳转下载对应的模型 ,把这些后缀为 safetensors 的文件下载下来,然后放到这个文件夹中即可。

(2. 使用 ①基本使用流程 这里以最常用的 canny 模型为例,模式选择文生图,canny 模型的作用就是提取出图片的线条信息并输入给 AI。 在界面最下面找到 controlnet 的插件,点击右边箭头展开参数,将这四个选项全部启用。 然后将预处理器和模型全部选择为 canny,这里要注意,前面的预处理器与后面的模型要对应。接下来点一下这个爆炸的 icon,在右边会显示所提取出的线条信息。 下面的那些参数我们先保持默认不变,接下来,修改采样器为 DPM++2M Karras,总批次数修改为 4,基础底模型改为“cetusMix_Coda2”,并且填入如下的提示词: 正向提示词:masterpiece, best quality, ultra detailed, A girl, cute, light smile, black hair, purple eyes, yellow clothes, standing, outdoor, long sleeves, 反向提示词:nsfw,(watermark),sketch, duplicate, ugly, huge eyes, text, logo, monochrome, worst face, (bad and mutated hands:1.3), (worst quality:2.0), (low quality:2.0), (blurry:2.0), horror, geometry, badpromptv2, (bad hands), (missing fingers), multiple limbs, bad anatomy, (interlocked fingers:1.2), Ugly Fingers, (extra digit and hands and fingers and legs and arms:1.4), crown braid, ((2girl)), (deformed fingers:1.2), (long fingers:1.2),(bad-artist-anime), bad-artist, bad hand 然后我们点击生成即可。可以看到,最终生成的图片是在初始的真人的基础上生成的。

(3. 具体参数介绍 低显存模式:如果你的显卡内存小于等于 4GB,建议勾选此选项。 完美像素模式:勾选后,controlnet 会自动去匹配适合的像素大小。 允许预览:勾选后,点击爆炸 icon,在图片右边会展示所提取的图片特征信息 控制权重:可以调整该项 ControlNet 的在合成中的影响权重。 引导介入步数&引导终止步数:controlnet 对最终生成结果的控制步数范围比例。Guidance strength 用来控制图像生成的前百分之多少步由 Controlnet 主导生成。Guidance Start(T) 设置为 0 即代表开始时就介入,默认为 0,设置为 0.5 时即代表 ControlNet 从 50% 步数时开始介入计算。 canny low threshold & canny high threshold 更高的阈值下,所提取的线条更少,更低的阈值下提取的线条更多。 控制类型:更遵循提示词,更遵循 controlnet 输入的图像特征,或者均衡。 ①常用模型介绍 除了上面使用的 canny,还有几个常用的模型,我在这里给大家介绍一下其他模型的用途。 Depth 通过提取原始图片中的深度信息,获得前后景的关系,可以生成具有同样深度结构的图。一般用于提取物体边缘轮廓,没有物体内部的细节。 以这个模型为引导,生成的图片如下: Lineart 与 canny 类似,该模型对线稿的处理能力极为优秀。同样也是将图形提取成线稿,然后在此基础上进行上色与细节补充。 MLSD 该模型通过分析图片的线条结构和几何形状,来构建出建筑外框,适合建筑设计的使用。 Normal 适用于三维立体图,通过提取图片中 3D 物体的法线向量,绘制出的新图与原图的光影关系完全一致。此方法适用于人物建模和建筑建模,但更适合人物建模。 hed(边缘检测算法): canny 提取线稿更硬朗,hed 提取的线条更圆润 OPENPOSE 根据图片生成动作骨骼中间图,然后生成图片,使用真人图片是最合适的,因为模型库使用的真人素材。 目前已经有五个预处理器,分别是 openpose,openposefull,open posehand,openposefaceonly,openposeface,这五个预处理器分别可以识别身体姿态,姿态+手部+脸部,身体+手部,仅脸部,身体姿态+脸部。 我们这里以身体姿态为例, 上图中右边便是 openpose 提取出来的人物骨骼图,以此引导生成的图像如下,可以看到,图像里人物的姿势都与原图保持了一致。 这里顺便给大家推荐一个网站:点击跳转,可以从这里面下载人物的不同姿势的图片。 Segment 语义分割模型,标注画面中的不同区块颜色和结构(不同颜色代表不同类型对象),从而控制画面的构图和内容。 如上右图所示,每个色块代表不同的含义,完整的色块释义对照表如下: 在这个模型下,我们可以更自由地控制图片的生成。例如我们想要添加一个人,将预处理后的色块图下载后,在 PS 中添加一个人物轮廓的色块,颜色从表格中获得。然后再导入到 controlnet 中,注意这时预处理器要选择无,后面依旧选择 seg,如图所示。 再次点击生成后,可以看到,图片按照我们的要求在中下部添加了一个拿箱子的人,并且由于我们选择的模型是二次元的,所以生成的图片也是二次元的。但整体的结构是遵循我们的指令的。 教程整合梳理与互联网不同教程,仅供学习使用。

StableDiffusion AI绘画一些实用技巧汇总

点击查看相关技巧

|